En el Primer Encuentro de este Taller pusimos sobre la mesa las siguientes cuestiones:

En el Primer Encuentro de este Taller pusimos sobre la mesa las siguientes cuestiones:

1- La investigación en redes (sean referidas a la sociedad humana como a las no humanas) tiene raíces muy diversas: desde la astrología y sus patrones zodiacales a las dramatizaciones que un psiquiatra vienés hacía con presidiarios, dejándolas en representadas en grafos.

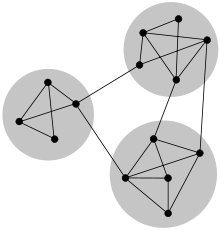

2- Las redes son sistemas, pero sin borde, por eso algunos hablan de Post-Sistémica: cuando un nodo de una red es estimulado es muy probable que los otros nodos se vean afectados, dependiendo de la topología de conexiones que los conecten.

3- Los nodos son dependientes de posición en la red: en general las redes tienen distribuciones predecibles o rankings que permiten ordenar a cada nodo en importancia, influencia, peso, etc.

4- Los enlaces pueden ser unidireccionales (Twitter) o bidireccionales (Facebook), también cortos (dentro de un mismo cluster) o largos (conectando clusters).

5- Mencionamos que la aplicación concreta del Análisis de Redes a fenómenos sociales suele permitir resultados significativos y económicos, a condición de que sean bien utilizados. Esto a su vez habilita modos de intervención diferentes a los basados en promedios.

6- La culturómica (Bigdata de los hechos culturales) es el estudio de fenómenos que surgen de la detección de patrones mediante la recolección y búsqueda de patrones en reservorios de datos. La detección de patrones se ha visto agilizada recientemente por la técnica machine learning y deep learning que veremos mas adelante.

Bien, en este encuentro, además de la exposición y debate con Jorge Miceli, les proponemos avanzar sobre siguientes cuestiones; a saber:

1- Cuando se trata de cuestiones de gran complejidad y escala el Análisis de Redes Sociales (ARS) resulta un método de investigación y evaluación útil y adaptable que puede ser utilizado por organizaciones con o sin ánimo de lucro. El periodismo de autor, en la sociedad posthumana, irá girando progresivamente hacia un periodismo de datos, donde el lugar de la autoría va a quedar básicamente en el punto de la selección del mejor algoritmo de detección de patrones predictores. Una de las primeras experiencias en ese sentido son los abordajes del fárrago de datos de los Panama Papers, como vamos a ver mas abajo.

1- Cuando se trata de cuestiones de gran complejidad y escala el Análisis de Redes Sociales (ARS) resulta un método de investigación y evaluación útil y adaptable que puede ser utilizado por organizaciones con o sin ánimo de lucro. El periodismo de autor, en la sociedad posthumana, irá girando progresivamente hacia un periodismo de datos, donde el lugar de la autoría va a quedar básicamente en el punto de la selección del mejor algoritmo de detección de patrones predictores. Una de las primeras experiencias en ese sentido son los abordajes del fárrago de datos de los Panama Papers, como vamos a ver mas abajo.

2- Es decir que los algoritmos que intervienen en las plataformas de redes sociales, así como los que procesan la Bigdata, mejoran la comprensión de los fenómenos sociales. En la medida que se vayan familiarizando con Gephi vana ver las diferentes posibilidades que les brindan la selección de algoritmos.

Ahora bien. ¿Qué es un algoritmo? En principio es un conjunto de reglas concretas y secuenciadas que permiten que se produzca un comportamiento predefinido con un objetivo mensurable.

En términos generales cosas como sumar, fabricar una escoba, abrir una puerta, contestar un email o usar un artefacto electrónico suponen la existencia de un flujo de reglas secuenciadas para que se produzca ese resultado buscado (lease resolver un problema).

Antecedentes

El origen de estas ideas lo vimos en la astronomía griega, pero también lo podríamos asociar a los primeros estudios epidemiológicos, cuando la peste bubónica creaba larguísimas listas de mortalidad (Bills of Mortality) en las parroquias de Londres, que fueron el deleite de Graunt un vendedor de telas del siglo XVII.

El origen de estas ideas lo vimos en la astronomía griega, pero también lo podríamos asociar a los primeros estudios epidemiológicos, cuando la peste bubónica creaba larguísimas listas de mortalidad (Bills of Mortality) en las parroquias de Londres, que fueron el deleite de Graunt un vendedor de telas del siglo XVII.

El comercio de tejidos hoy es uno de los mas estadísticamente predecibles aun en países inestables como Argentina, he conocido personalmente fabricantes que han errado en menos de diez el cálculo de jeens a producir por años. En 1662 publicó un libro con el intrigante nombre de “Natural and Political Observations …”

En extensas matrices que hoy cargaríamos en un excel o programa equivalente listaba enfermedades como letargo, enfermedad del sueño, dolor, sífilis o peste bubónica y otras como “El mal del Rey ‘,una inflamación de los ganglios linfáticos en el cuello, que sólo podía ser curada por el toque de un monarca y que Graunt desestimó acertadamente, ya que hoy sabemos que era una forma de tuberculosis.

Graunt había encontrado un patrón que definía si un padecimiento era o no una enfermedad. Y lo había hecho hace mas de tres siglos!

En matemáticas los algoritmos son una cosa seria y que pueden producir enormes beneficios a sus creadores. Google Search mismo no es más que un complejo algoritmo hecho a su vez de ecuaciones que evolucionan transformando los datos de un problema (la búsqueda) en los datos de una solución (los resultados).

En Análisis de Redes Sociales como decíamos los conceptos de intermediación, centralidad y cluster son claves. Son los conceptos-nodo con mas y mejores relaciones dentro de la red de conceptos. La intermediación es el número de caminos más cortos entre pares de nodos que se ejecutan a través de él. Es una medida de la influencia de un nodo sobre el flujo de información entre otros nodos, especialmente en los casos donde el flujo de información a través de una red sigue principalmente el camino más corto disponible.

En el caso del comercio medieval es facil de entender: un puente crea un camino súper corto a través de los Alpes e inventa toda la Europa moderna, pero hoy en día ya están casi todos los puentes geográficos claves construidos, pero trabajando con grandes bases de datos la cosa no es tan así.

Por ejemplo el algoritmo de Girvan-Newman agrega una idea muy simpática pero muy productiva: pasa a calcular los caminos mas cortos no sobre los nodos, sino respecto a los enlaces en si mismos, a los que evalúa como si fueran nodos.

Por ejemplo el algoritmo de Girvan-Newman agrega una idea muy simpática pero muy productiva: pasa a calcular los caminos mas cortos no sobre los nodos, sino respecto a los enlaces en si mismos, a los que evalúa como si fueran nodos.

Los pasos son los siguientes:

1- Calcula el grado de intermediación para cada enlace

2- Remueve los enlaces con mas alto score

3- Repite el paso 1

4- Repite el paso 2

Finalmente remueve todos los enlaces hasta no poder repetir el punto 3, el resultado es la detección de nodos importantes de una red (por ejemplo el instructor de una escuela de Karate) comunidades en redes complejas y extensas.

Otros algoritmos para encontrar comunidades en redes extensas son:

Clauset-Newman-Moore: es un algoritmo de aglomeración, a se decide a cada paso por la optimización de modularidad.

El algoritmo de Spinglass utiliza como modelo de spinglass para encontrar las comunidades dentro de una red.

El algoritmo Walktrap encuentra subgrafos densamente conectados mediante la realización de paseos aleatorios. La idea es que paseos aleatorios tenderán a permanecer dentro de las comunidades en vez de saltar a otras comunidades.

Otro ejemplo es “Chinese Whispers”: un algoritmo basado en un paper de Chris Biemann.

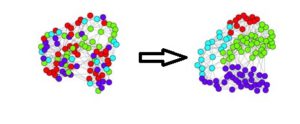

El proceso de agrupación de objetos, de acuerdo a alguna similitud entre sí, puede reducir en gran medida la complejidad conservando consistencia. La representación con dimensiones en el espacio representa objetos (nodos) y sus relaciones (atistas).

Chinese Whispers es un algoritmo básico pero bastante eficaz para particionar nodos de grafos no dirigidos. El nombre se origina en un juego de niños, también conocido como el “teléfono descompuesto”.El objetivo del juego es llegar a distorsiones divertidas derivadas del mensaje original, pasándolo a través de varios puntos de paso por medio de canales muy ruidosos.

El algoritmo origina conexiones al azar y recolecta como responden los nodos, tiene por objeto la búsqueda de grupos de nodos que transmiten un mismo mensaje a sus vecinos y si bien muchas veces se encuentra cosas obvias (ej alumnos de una misma división), el algoritmo es capaz de identificar cosas poco esperables, como por ejemplo que los republicanos viven en casas grandes.

Lo que no queremos ver

Las plataformas de redes sociales han implementado regularmente algoritmos de formacion de cominidades desde hace una década. El miembro de MoveOn.org ELi Pariser bautizó esta idea como “burbuja filtrada” (me gusta mas que la traducción “filtro burbuja”): el resultado es que recibiremos principalmente noticias agradables, familiares y que confirmen nuestras creencias. Como estos filtros son invisibles, no vamos a saber lo que se nos oculta.

Los algoritmos determinarán a que estaremos expuestos en el futuro, dejando menos espacio para la innovación y el intercambio de ideas con personas de intereses diferentes (eso es también verdad para sitios como OkCupid).

La idea de Burbuja Filtrada revela cómo esta personalización algorítmica podría socavar el propósito original de la Internet como una plataforma abierta para la difusión de ideas.

Los algoritmos y el análisis de redes funcionando juntos

(Presentación de Jorge Miceli)

[embeddoc url=»https://lukasnet.com.ar/blogwp/wp-content/uploads/2016/09/ars-panama-papers.pdf» download=»all»]