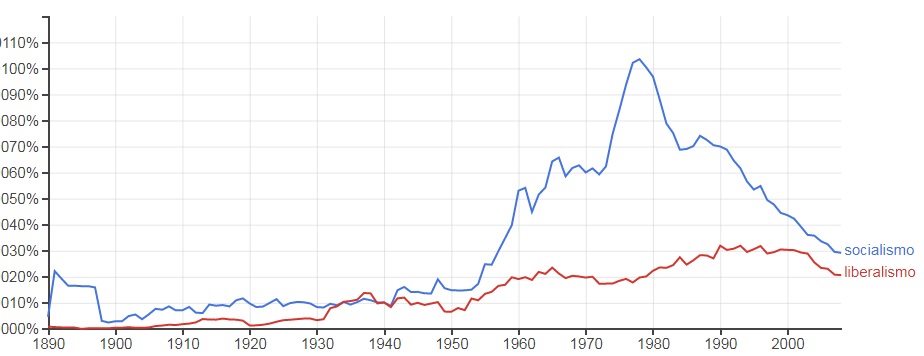

En esta imagen vemos la frecuencia de aparición de dos palabras en miles de libros analizados por Google. El gran tema es si podemos decir algo de lo que va a suceder en el futuro con esas palabras conociendo estas curvas.

Y la verdad es que no, lo que tendremos serán muchos datos, pero nada sobre el futuro. Tenemos tendencias, pero las cosas cambian.

La culturómica (Bigdata de los hechos culturales) tiene esta mochila, porque estudia fenómenos que repiten pero que pueden no volver a hacerlo. La detección de patrones se ha visto agilizada recientemente por la técnica machine learning y deep learning y cada vez explica mejor lo que ve o lo que sucedió, pero no lo que va a pasar.

Los algoritmos que intervienen en las plataformas de redes sociales, así como los que procesan la Bigdata, mejoran la comprensión: podemos reconstruir censos que no se hicieron, pero no podemos decir que datos van a recolectar en el futuro.

Hoy el el 99 % de nuestra data es digital, solo el 1 % con suerte es analógico. Lo analógico crece como la economía, más o menos al 3 % anual, lo digital se duplica cada 2 años y medio.

Cuando vemos la BigData viniendo del pasado tendríamos que ser cuidadosos en no cegarnos por los atributos y los promedios, siempre hay que buscar las interacciones.

En fin. hemos ido balizando el trípode para analizar la complejidad. Redes, territorios y juegos y ahora lo vemos en modo siglo XXI: inteligencia artificial, BigData y algoritmos.

Espero que estos debates (acá más o menos desgrabados) que hemos tenido hasta acá les hayan ayudado a contar con herramientas para repensar el abordaje de la complejidad.

Nos vemos!

Comments are closed, but trackbacks and pingbacks are open.