No soy la persona más adecuada para defender una tesis y menos si es de mi autoría.

Soy de los que cambian de opinión y que no se consideran a sí mismos una fuente confiable, así que en general las cosas que escribí o decidí hace unos años hoy son más objeto de crítica que de consonancia argumental.

Independientemente de estas apreciaciones estoy acá para defender mi trabajo y el de las personas que me ayudaron a terminarlo.

Agradecimientos

No puedo comenzar, antes de sumergirme en el berenjenal de defender lo indefendible, sin agradecer a todas las personas que desinteresadamente participaron en este proceso.

Antes que nada a mi familia, a la que quité horas de vida de hogar y de whatsapp. También a los compañeros de la academia social y del mundo de la informática que me dieron varias manos de ayuda y especialmente a mi desconocida Alexandra Elbakyan, que fundó en 2011 la web Sci-Hub gracias a la cual navegué dias y dias sobre las olas de papers científicos.

No puedo olvidarme tampoco de los anonimizados usuarios de 4SQ y otras de redes sociales que participaron en las encuestas, cuestionarios o simplemente con sus checkins, ideas y vida misma en las plataformas de redes telemáticas y a todo el personal de la Secretaría de Doctorado, docentes de seminarios, compañeros de cursada y a los miembros del jurado, que tuvieron que atravesar una tesis por momentos compleja y por otros complicada, y por supuesto a mi Director de tesis Dr José Luis Fernández, de quien aún no se como es que se embarcó en este recorrido y menos aún cómo no se arrojó a tiempo por la borda.

Dificultades

Acercarse a Foursquare, al menos como hicimos al principio de este proyecto, tuvo algo de viaje a un país desconocido. Fue un link a un lugar sorprendente, tanto que al poco tiempo decidimos llamarlo neolugar. No solo era un territorio desconocido, sino también un espacio que iba cambiando durante el mismo proceso de la investigación. Independientemente que este hecho afectaba gravemente las condiciones de toma de la muestra, como debíamos comportarnos en términos generales?

Debíamos hacer como Jane Jacobs en «Vida y Muerte en las grandes ciudades» señalando los riesgos del cambio no lo suficientemente comprendido, pero aplicado a Foursquare? Se trataba de describir los cambios, las pérdidas, las ganancias y la tendencia general del proceso de transformaciones? O debíamos descartar lo que cambiaba y ceñirnos a lo que perduraba? ¿Qué debíamos hacer? ¿Se trataba de agregar capas para cada período o considerar a 4SQ como un continuo en el que las tensiones entre el cambio y lo mismo se iban desplegando con diferentes suertes?

El problema de las conexiones

Acá debimos ser cuidadosos, tal como señaló Le Goff en su último libro, no siempre es lo mejor hacer capas temporales pero tambien nos daba una señal: en la Edad Media se produjo un hecho clave para entender el poder de lo relacional en los procesos sociales, de territorialización y los comportamientos sociales. Cuenta Le Goff que en 1237 un grupo de constructores le pidió ayuda al diablo para hacer lo imposible: colocar sobre la garganta de Schöllenen un puente, el puente de San Gottard, que sería ni más ni menos que la conexión más breve y económica entre dos campos económicos, culturales y militares de correspondientes a las cuencas del río Rin (y así el mar del Norte) y la del río el río Po (Mediterraneo).

Le Goff propone que el nacimiento de la revolución del mercado, incluidas las rutas de navegación, los burgos como controladores de la reducción de sistemas de peajes interburgos, las innovaciones en la producción agrícola y otros fenómenos que se producirían incluidas las pestes tuvieron su chispa en ese enlace, por su potencia de intermediación.

Sin embargo para la organización de la tesis debíamos excluir muchas ramificaciones, desde ya Le Goff no parecía tener mucho que aportar respecto a 4SQ, pero sobretodo nos encontramos con el espejismo de las visualizaciones en los programas de análisis de redes sociales.

En seguida nos asombramos de hallazgos que descubirmos absurdos (como el efecto de la segunda letra del apellido en la aparición de propiedades de red) pero que al mismo tiempo nos alertaba de lo problemático que sería estar embarcados en un proyecto tan absurdo como nuestros descubrimientos azarosos.

Además de las fichas, resúmenes y apiladas de papers hicimos otra cosa: creamos un grupo público y le pedimos a los amigos, colegas y alumnos interesados en nética que se sumaran para colaborar, discutir y criticar, con lo que tuvimos un grupo de más de 20 personas trabajando colaborativamente.

Con el Dr. Fernández tuvimos varias reuniones al principio del proyecto y de todas volvímos al punto cero. Varias veces comenzamos la recolección de datos y por factores imprevistos tuvimos que recomenzar.

Desde el punto de vista de nuestro objetivo central, es decir presentar una tesis para aportar al campo académico, los problemas más comunes de ese inicio eran:

¿Cómo inscribir el trabajo dentro de las ciencias sociales y que no se tratara de una tesis para ciencias de la computación o geografía?

¿Cómo evitar las dispersiones temáticas cuando aparecían tantas novedades a medida que recolectamos materiales?

¿Cómo formular los objetivos de acuerdo a los de las fichas que íbamos creando y sobretodo cómo reducir el ruido?

Nos preguntábamos:

¿Es 4SQ un restrictor comportamental de las unidades sociales?

¿Se puede comprender a 4SQ usando las herramientas de ARS?

Tratándose de plataformas millonarias en usuarios ¿Podriamos detectar grupos de actores claves informacionalmente?

¿Podríamos establecer patrones de geolocalización y movilidad social?

¿Se podría hacer además todo esto con programas Open Source?

¿Existe alguna forma de taxonomía urbana basada en redes?

Hipótesis

Entonces hicimos como se hace en estos casos y definimos nuestras preguntas y las posibles respuestas, las guías de nuestro trabajo, manteniéndonos alertas a lo que pudiera suceder en el camino.

Nos dijimos:

¿Los checkins de los usuarios con mayor grado nético predicen el comportamiento del resto de los usuarios a partir de ser difusores claves de información (influenciadores)?

¿Es factible establecer con los datos obtenidos con la metodología implementada (lectura automatizada de APIs) establecer un centroide urbano genérico que de cuenta de propiedades de red y de locación?

El proceso metodológico y sus dificultades

Estábamos ya en carrera. Rápidamente nos pusimos en contacto con Mariano Amartino, un especialista en nuevos medios que usaba profusamente Foursquare y que, además, era el que entre nuestros contactos quien más amigos tenía en la plataforma.

En algún momento desgranamos la idea de que los materiales iban a tener que ser recolectados de las APIs de 4SQ, Facebook y Twitter. Con la última tuvimos que hacer un descarte luego de varias semana tratando de automatizar la recolección de datos, para lo que además era necesario hacer un trámite especial, declarándose como investigador científico y validar con el respaldo de la institución esa actividad.

Esto no fue posible en la práctica, entonces nos centramos en 4SQ y desde ahí obtuvimos datos de Facebook. Pero debíamos movernos con los cuidados del caso, es decir, centralmente nuestro texto final debería tratarse de un documento que fuera reconocible claramente dentro del programa de las ciencias sociales y más allá de los aspectos cuali y cuantitativos específicos, debíamos sortear dificultades con un objeto no sólo cambiante sino además poco estudiado hasta esa fecha y que observaríamos con herramientas que deberían cambiar durante el proceso.

Decidimos entonces utilizar un tríptico de abordaje. En primer lugar reuniríamos el trabajo exploratorio directo, con los usuarios y no usuarios, la revisión detallada de los comportamientos densamente explicitados, la detección y formación de pequeños grupos y eso se ubicaría dentro de la solapa etnográfica.

En un segundo lugar los materiales que recolectaríamos leyendo en forma automatizada las datos de las APIs en cuestión los separaríamos en dos áreas, la redológica y la territorial: siendo para la segunda imprescindible la geolocalizacion de los usuarios definimos a esa vertiente como la locativa de nuestra investigación.

Teníamos entonces las tres ventanas para mirar dentro del problema: la etnográfica, la redológica y la locativa.

Los problemas no fueron pocos, detallemos algunos:

La API de Foursquare y la de Facebook tienen una tasa de consultas por hora que debe respetarse. En el caso de FB era de 1000 consultas/hora, en Foursquare de 500 consultas/hora. Esto fue contemplado inicialmente. La API graph de facebook requería validación, un usuario real, con un token generado al efecto para poder consultar datos lo que fue corregido durante las pruebas, antes de la recolección.

No se podía consultar en Foursquare a más de los 10 primeros contactos de cada usuario. Y no existía además documentación de cuales eran los 10 provistos por la plataforma. Es decir, no había un orden definido y documentado o racional de cuales eran los contactos recolectados. Se trataba de un agregador de incertidumbre, sin embargo hicimos varias pruebas con usuarios conocidos y lo que pudimos suponer con cierto grado de verosimilitud era que el principio se aplicaba a todos los usuarios, y que probablemente recolectaban a los 10 últimos usuarios con los que el usuario semilla había tenido algún tipo de vinculo (comentario, amistad, visualización).

Por la metodología que se utilizó en los programas, cada usuario era representado por tres archivos físicos en el disco utilizado.

La API Graph, de Facebook, tuvo un estado original o de transición entre el Facebook sin permisos al que conocemos hoy en dia, donde existe una granularidad de permisos sorprendente. Pudiendo definir quién veía cada publicación y quien no. Esto favoreció el estudio, porque al comienzo de la recolección, no había permisos y muchos datos eran públicos. Luego con el paso del tiempo se fue restringiendo e incidió negativamente en las consultas de FB y motivó que se descartaran la mayoría de los datos recolectados en esa plataforma.

No existía además en principio un proceso de validación muy exigente con los datos, por lo que se utilizaron mensajes de error de consulta como acuse de recibo de un problema en la recolección de datos. Esto fue corregido con el tiempo, y los mensajes de error fueron reemplazados por datos nulos.

Cuando hubo cortes de energía durante la toma de archivos, y el proceso de recolección no estaba preparado para retomar desde donde fue finalizado, se volvía a comenzar el paso completo de recolección o link lo que luego fue subsanado creando backups provisorios.

En la primera etapa de recolección no fue previsto que un contacto apareciera varias veces en la lista de amigos de cada sujeto de investigación, esto provoco la repetición de consultas, perdida de tiempo y de espacio en disco valioso. Esto fue corregido durante el proceso de captura y/o procesamiento de los datos.

Fue necesario un proceso de conciliación entre lo bajado, y lo que faltó por errores en el proceso. Esto fue remediado con un programa al efecto, pero provocó un desfasaje entre la toma original de datos y el intervalo de tiempo hasta la corrección de errores.

Existió un error significativo en la recolección porque en la interpretación de la lista de amigos de un usuario del primer anillo, fue considerado un valor adicional con un formato erróneo. El formato erróneo y divergente permitió la rápida y fácil corrección del error, pero provocó en los siguientes links, la recolección y existencia en el estudio de datos no útiles. Esta corrección fue realizada al final de la toma durante la redacción de la tesis, cuando fue observado el error y significó eliminar medio millón de usuarios de la muestra.

Con las encuestas webs tuvimos otras dificultades. Después de varios intentos supimos que el envío de las mismas por email, el sistema que habíamos creído inicialmente que nos serviría, prácticamente no tuvo resultados. Incluso a los amigos había que insistirle varias veces y aun así pocos nos completaban los formularios. Así tuvimos que recurrir a una plataforma contratada de envío de emails, conseguir bases de datos de usuarios intensivos de plataformas de redes y enviar la consulta a mas de 130 mil destinatarios de email. El proceso hubo de repetirse 3 veces hasta que se consiguió superar las 250 respuestas completas.

Un problema de programación nos envió además todo los no sabe no contesta al mismo archivo, por lo que no pudimos desmezclarlos de cada respuesta.

Por último tuvimos tambien dificultades con los usuarios, especialmente una que no habíamos previsto, ya que cometimos el error inicial de comparar a 4SQ con otras plataformas y fue que los usuarios dejaban rápidamente de usarla, habiendola o no desinstalado de su smartphone.

Definidos los tres anclajes los pusimos a rodar alrededor de un concepto que debimos definir: el neolugar, que a los efectos de nuestra indagación sería la representación informacional de un espacio socialmente compartible en una plataforma de redes sociales, con o sin existencia en el mundo real, y que pudiéramos describir desde nuestros tres lentes.

Resultados obtenidos

1- Etnográficos

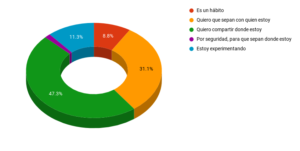

Encontramos que los usuarios utilizaban la aplicación con un fin escénico, ya que principalmente usaban la plataforma para verse (en ella) y ser vistos por sus amigos. Esta parecía ser la faceta más importante del juego, es decir el aspecto de simulacro. Poca referencia hicieron a la búsqueda de insignias.

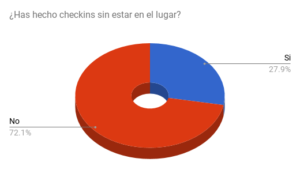

También encontramos que la práctica de inventar locaciones o hacer checkins falsos era mucho más habitual que lo que inicialmente habíamos esperado, rondando una de cuatro usuarios.

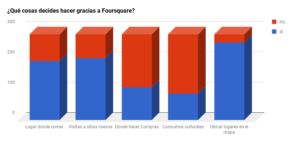

Al mismo tiempo el tipo de apropiación de la plataforma mostraba desinterés por los comentarios de otros usuarios, siendo el interes principal mostrarse en tal lugar o con alguien

Dado que habíamos encontrado que los usuarios utilizaban en buena medida la plataforma para mostrarse o ver que hacían sus amigos (por sobre otras opciones por seguridad, descubrimiento de lugares, etc) pudimos conjeturar que nos encontrábamos frente a fenómenos de curaduría, mímesis, enlace preferencial y autorganización interaccional del neolugar.

En las entrevistas los usuarios insistieron en que la dificultad de integración con Instagram los había hecho desistir de continuar utilizando la aplicación, algo que luego aparentemente se intentó subsanar con acuerdos con Snapchat.

La mayoría de los usuarios abandonaron la plataforma y una hipótesis causal es que hayan comprendido las reglas del juego, pero no como jugarlo vitalmente. En la dimensión lúdica deben buscarse marcos explicativos de fenómenos opacos en 4SQ.

2- Redológicos

Los datos fueron abundantes luego de 2 años de recolección, y casi un año de procesamiento. Obtuvimos 1,3 millones de usuarios conectados en 6 anillos al nodo inicial Mariano Amartino de los que luego desgranamos aproximadamente 100 mil usuarios distribuido en 5 ciudades: Buenos Aires, San Pablo, Barcelona, Rosario y Córdoba. Habíamos seleccionado inicialmente la ciudad de Sevilla pero obtuvimos usuarios sin conección entre ellos, por lo que la descartamos.

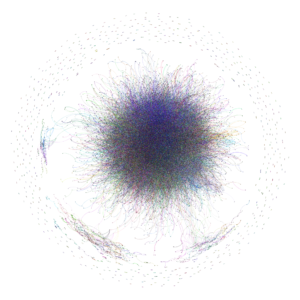

Las primeras visualización nos entusiasmaron, pero indudablemente eran poco prometedoras en términos de producción de interpretación de los datos.

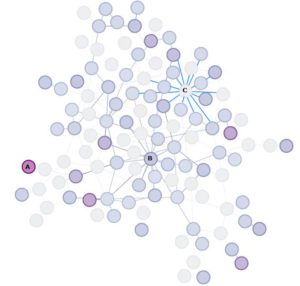

Pero luego de un filtrado paciente en función de grados de intermediación (nodos mejor conectados), que validamos mediante el Coeficiente Medio de Clustering (una medida de la vitalidad y cohesión de la red) seleccionamos 51 usuarios, más o menos el 1 % del total de usuarios que habían declarado a Bs As como su dirección en el perfil. Nótese que se excluyeron todos los links que apuntaban fuera de ese grupo de usuarios.

Finalmente encontramos que en ese grupo existían propiedades interesantes, si las relacionabamos con su grado total de red.

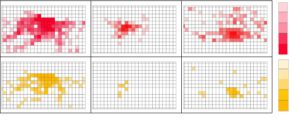

En el gráfico de abajo los usuarios con mayor gradiente de color son los mas conectados con la totalidad de los nodos de la ciudad (A) en tanto que podemos observar usuarios muy conectados en la elite (B) pero poco enlazdos con el resto, en tanto que un grupo de nodos (C) se caracterizaron por ser integradores de la elite, pero estar ademas bien integrados con el resto de los individuos.

Pudimos además hacer una evaluación de sus propiedades de red y desde ahí poder conjeturar que Foursquare podría ser comparada con otras configuraciones néticas, incluso las exteriores al campo de las ciencias sociales.

3- Locativos

Luego nos centramos en las latitudes y longitudes que registraban los usuarios como último checkin en 4SQ y concluimos que puede ser analizado y comprendido con las herramientas propuestas de análisis territorial.

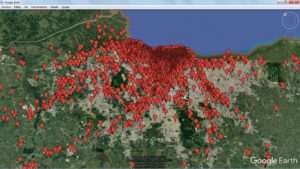

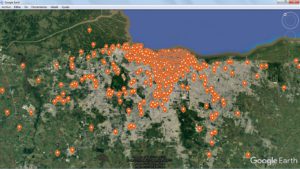

Luego pusimos a los usuarios en el mapa.

Primero establecimos las vías de circulación, como se ve en la imagen de abajo.

Luego comparamos a los usuarios de cada ciudad con los usuarios mas conectados.

Por último creamos huellas dactilares para cada ciudad, de modo d obtener visualizaciones rápidas en intuitivas de las locaciones encontradas.

Excepto en Barcelona, obtuvimos una correlación entre las locaciones de los usuarios totales y los más conectados.

Conclusiones

Entonces lo que podemos decir es que desde la perspectiva redológica 4SQ puede ser analizado y comprendido con las herramientas propuestas por el Análisis de Redes Sociales. Parece poco, pero no lo es. Se habla de «redes sociales» pero había que poder analizarlas como tales. Las propiedades de red (centralidades, diámetro, rankeo, densidad, modularidad, Coeficiente de clustering) permiten una descripción de su estructura y la puesta en relación con otras redes sociales. Existe una distribución de lo fuerte y lo débil (lazos, distancias, territorios) que puede ser descripta a partir de algoritmos de comunidades (en este caso utilizamos Markov, Chinese Whispers, Intermediación). Conjeturamos la posibilidad de establecer un controide topologico pero para eso como bien señala Jorge Miceli deberíamos adentrarnos en los programas de sintaxis espacial, los mismo es aplicable a los aspectos lúdicos, donde tambien hay mucho por andar.Es importante señalar que nuestroa hallazgos no son extendibles fuera de las comunidades de usuarios de 4SQ.

Las ciudades presentan descentralización, fragmentación y gravitación dispersada

Los usuarios podrían seguir patrones de “vuelos de Levy”, es decir muchos pequeños desplazamientos y pocos largos desplazamientos. El asunto debe abordarse meticulosamente con sintaxis espacial.

Respeto a las conclusiones etnográficas encontramos que 4SQ puede ser analizado y comprendido con las herramientas propuestas de análisis etnográfico.

Encontramos fenómenos de curaduría, mímesis, enlace preferencial, autorganización interaccional del neolugar.

La mayoría de los usuarios abandonaron la plataforma y una posibilidad es que hayan comprendido las reglas del juego, pero no como jugarlo.

Discusión

Comprendimos llegados a este punto que una serie de procesos podrían optimizarse (multiplicar los usuarios semillas, mejorar los scripts de limpieza, procurar mejor capacidad de procesamiento). Todo esto independientemente de los avances recientes en programación y que merecen un documento aparte.

Entre los aspectos más importantes debemos recalcar la importancia de la temporalización de la captura de datos. Creemos tambien que mucho se podría producir si las empresas basadas en publicidad mediante plataformas de redes sociales y las compañías telefónicas proveyeran datos anonimizados y legalmente controlados a la academia y no solamente a los gobiernos locales y nacionales.

Más genéricamente consideramos que se deben mejorar las condiciones de trabajo en la academia para que no quede tan rezagada respecto a las consultoras especializadas en BigData, como sucede en la actualidad (caso Xpapers por ejemplo).

Queremos resaltar la necesidad de enfoques transdisciplinarios por la complejidad del fenómeno redo-locativo y la importancia de su comprensión dada las implicancias sociales del asunto.

Futuras investigaciones

LLegados a este punto la tesis ha caducado. Avanza hacia atrás y poco a poco va adquiriendo el rol arqueológico que posiblemente será el más valioso. Ver como funcionaba Foursquare antes de la era de los algoritmos burbuja.

Nos movemos hacia la ubicuidad de la geolocalización y su implicancia en las nuevas formas de postsubjetividad y las estrategias de resistencia que le reaccionaran es uno de los asuntos candentes.

Será inevitable entender mucho mas de los filtros burbuja y su relación general con las plataformas de redes telemáticas y las nuevas tecnologías de control mediante detección de patrones

La evolución de las aplicaciones (algoritmos sociales, machine learning, bots, singularidad, nuevas formas de agencia, redes de autómatas, ecología digital, remediación informacional) no debería dejarnos afuera de la reflexión sobre el “lugar” de la localía: su reinvensión y eventual di-solución.

Nos movemos como dijimos y por delante tenemos desafíos como la Posthumanidad, las nuevas formas de privacidad y la difusión obligada de la culturómica.

Creemos que vale la pena.

Para la posteridad una foto que no sacamos con el Dr. Fernandez hace tres años, donde queda demostrado que hay que en #fsoc se trabaja con uniforme.

TEXREDES2020 (5) – LuKasnet Blog

[…] plataformas telemáticas. Es el dispositivo donde se sorprende nuestro avatar. Puedo recomendarles una tesis sobre el […]